Im ersten Teil zum Thema „Kosten sparen in Azure“ haben wir uns mit den Reservierungen auseinander gesetzt. In diesem Artikel soll es um eine Alternative dazu gehen – den „Compute Savings Plans“.

Bei den „Compute Savings Plans“ bzw. „Savings Plans for Compute“ handelt es sich um eine weitere Möglichkeit, durch ein langfristiges Commitment Rabatte zu bekommen. Sie verfolgen also ein ähnliches Ziel wie Reservierungen – funktionieren dabei jedoch völlig anders.

Anders als bei Reservierungen muss man sich bei den Savings Plans nicht für einen bestimmten Ressourcen-Typ festlegen. Die gebuchten Savings Plans gelten für alle unterstützten Ressourcen-Typen. Das sind aktuell:

- Azure Virtual Machines (*)

- Azure App Service

- Azure Functions premium plan

- Azure Container Instances

- Azure Dedicated Host

- Azure Container Apps

- Azure Spring Apps Enterprise

(*) Da Savings Plans für VMs gelten, gelten sie auch für alles, was durch die regulären Nutzungsgebühren von VMs abgedeckt ist, also z.B. Virtual Machine Scale Sets (VMSS), Azure Kubernetes Service (AKS) oder Azure Virtual Desktop (AVD).

Man bucht auch nicht eine bestimmte Menge oder Instanzen-Anzahl von einem konkreten Dienst, sondern definiert eine stündlich zu zahlende Summe. Diese Summe wird dann eingesetzt, um zu rabattierten Preisen die verwendeten Dienste der entsprechenden Ressourcen-Arten zu bezahlen. Dabei werden automatisch die Services mit dem höchsten Rabatten genutzt.

Rechenbeispiel

Um dies besser zu verstehen, erkläre ich es an einem einfachen Beispiel:

Nehmen wir an, wir haben eine einzige Azure VM, und zwar eine D8s_v5. Diese kostet regulär 0.441€/h (Nur Compute-Anteil). Bei einem 1-jährigen Savings Plan kostet die selbe VM noch 0.336€/h. Würden wir jetzt also stündlich genau 0.336€ in den Savings Plan einzahlen, wäre die VM damit vollständig abgedeckt und wir hätten ca. 24% Rabatt auf den Preis bekommen.

Wenn wir jetzt z.B. nur 0.200€/h in den Savings-Plan einzahlen würden, dann wären ca. 0.6h durch den Savings Plan abgedeckt. Die fehlenden 0.4h würden wir zum regulären Preis von 0.441€/h, also für ca. 0.176€, bezahlen. Somit hätten wir dann für die VM 0.376€ in dieser Stunde bezahlt.

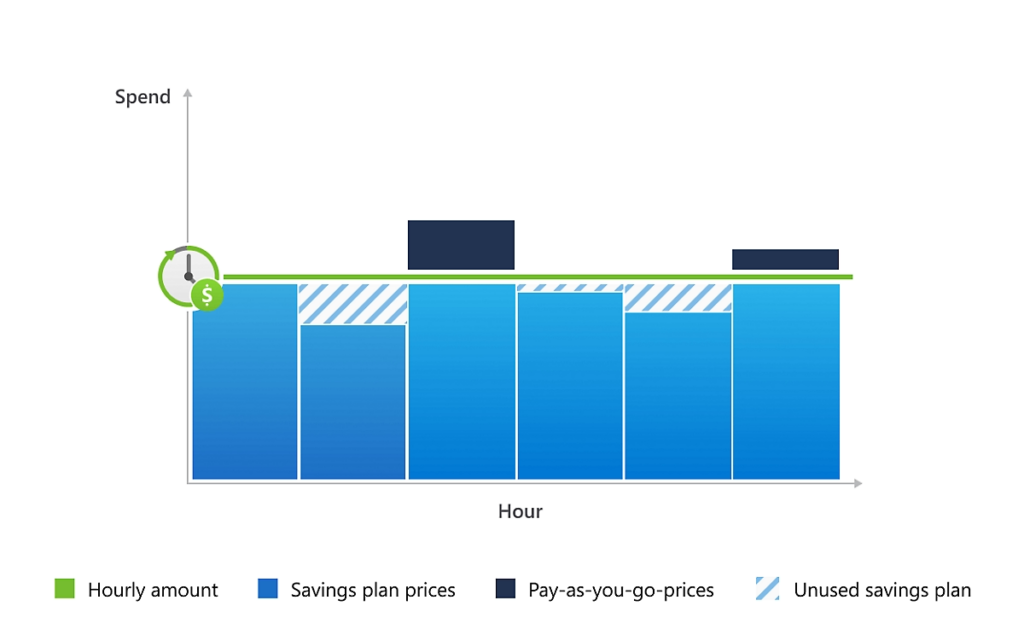

Hätten wir hingegen 0.400€/h eingezahlt, dann wäre die VM zwar vollständig bezahlt, wir hätten aber auch 0,064€ zu viel bezahlt. Dieser Betrag wäre verloren. Das zeigt diese Grafik recht gut:

Es ist dabei aber zu beachten, dass man Savings Plans derzeit nur in US-Dollar abschließen kann. Man muss die Beträge also ggf. umrechnen.

Gemeinsamkeiten mit Reservierungen

Savings Plans haben einige Gemeinsamkeiten mit Reservierungen, insbesondere:

- Laufzeit: Der Savings Plan kann für ein Jahr oder für drei Jahre gebucht werden – wobei es bei drei Jahren deutlich größere Rabatte gibt.

- Scope: Savings Plans werden ebenfalls für einen bestimmten Scope gebucht und gegen eine definierte Subscription abgerechnet

- Abrechnung: Savings Plans werden (obwohl der Betrag pro Stunde eingestellt wird) einmal monatlich abgerechnet (siehe unten)

- Over-Commitment: Es gilt „Use-it-or-loose-it„.

Weitere Unterschiede zu Reservierungen

Vorteilhaft ist, dass ein Savings Plan nicht für eine bestimmte Region gebucht wird – er gilt also für alle Regionen. Somit muss man sich auch nicht langfristig an eine bestimmte Region binden, wie es bei Reservierungen der Fall wäre.

Außerdem kann man eben auch nur Anteile seiner Ressourcen abdecken. Während man bei Reservierungen in der Regel immer volle Instanzen bucht, könnte man bei Savings Plans z.B. auch nur 50% aller Systeme abdecken. Würde man die Systeme dann später auf die Hälfte verkleinern, wäre das dann kein Problem.

Da man sich weder für eine VM SKU, noch eine Serie festlegen muss, kann man jederzeit auf die neueste Hardware-generation wechseln. Auch eine Modernisierung von VMs zu Containern (in AKS) wäre problemlos möglich.

Für Savings Plans sind jedoch keine weiteren Flexibilitäten oder Anpassungen verfügbar. Sie lassen sich nicht stornieren, umtauschen oder anderweitig verändern. Lediglich der Scope kann angepasst werden. Man muss also vorsichtig sein, damit man nicht zu viel bucht – es ließe sich später nicht mehr reduzieren! (Hinzubuchen weiterer Savings Plans ist hingegen jederzeit problemlos möglich)

Abrechnung von Savings Plans

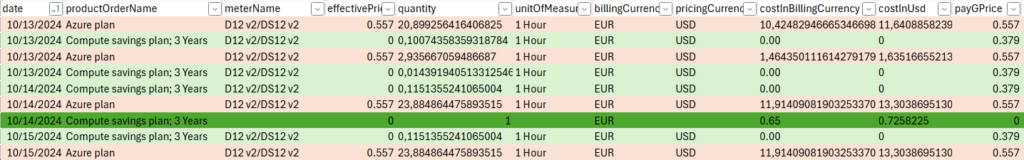

Wie oben erwähnt, wird jeder Savings Plan einmal im Monat abgerechnet. Dabei werden die monatlichen Stunden mit dem eingezahlten Stundensatz multipliziert (dunkelgrüne Zeile – hier wurde lediglich ein Betrag von 0.001 USD pro Stunde eingezahlt – das entspricht 0.65 EUR).

Am 15.10.2024 wurde dann eine D12 VM durch den Savings Plan teilweise abgedeckt – konkret hat man dafür 0.115h erhalten, die VM hat einen Savings-Plan-Stundenpreis von 0.379 USD. Die restlichen 23.884h des Tages wurden dann zum regulären Preis von 0.557 USD bezahlt.

Ab wann lohnt es sich?

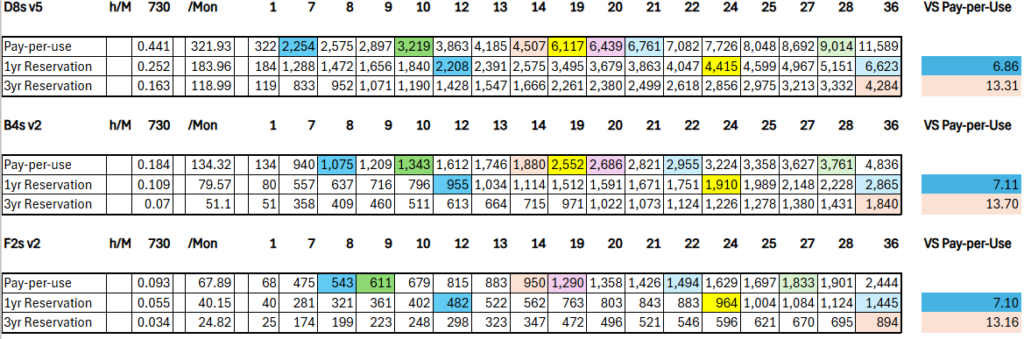

Auch hier wollen wir uns die Frage stellen, ab wann sich ein Savings Plan lohnt. Es gelten die selben Annahmen / Bedingungen wie im Artikel zu den Reservierungen beschrieben.

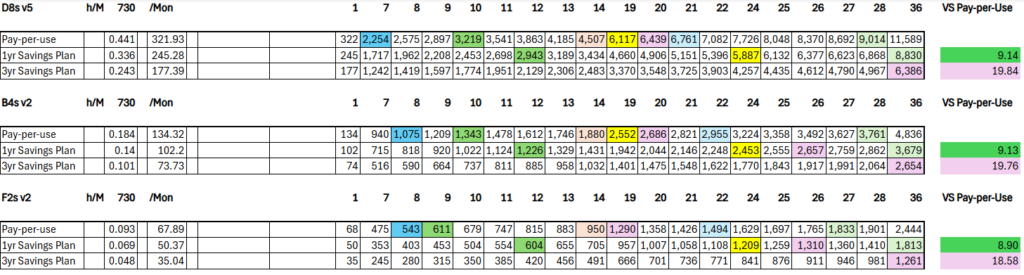

Beginnen wir mit dem einfacheren Fall eines 24/7 Betriebes und der Frage, nach wie vielen Monaten sich der Savings Plan „gelohnt hat“ (also die Gesamtkosten durch den Savings Plan geringer sind, als wenn die Laufzeit zum regulären Pay-per-Use Preis bezahlt worden wäre).

Wir können sehen, dass auch hier das Bild über die 3 VM-SKUs ziemlich gleich ist. Dabei

- …lohnt sich der einjährige Savings Plan nach ca. 9-10 Monaten…

- …lohnt sich der dreijährige Savings-Plan nach ca. 19-20 Monaten…

…im Vergleich zu Pay-per-Use.

Im Vergleich zwischen durchgehendem dreijährigem Savings Plan und einjährigem Plan plus Restzeit mittels Pay-per-Use ist der dreijährige Plan nach ca. 22-23 Monaten günstiger.

Wenn man in Betracht zieht, 2 Jahre hintereinander einen einjährigen Plan zu buchen, dann lohnt sich das in der Regel ab 19 Monaten (gelb markiert) im Vergleich zu Pay-per-Use. Und dann ist der 3-jährige Plan auch erst nach ca. 26 Monaten die bessere Option – bis dahin wären 2 Jahre im einjährigen Plan und der Rest in Pay-per-use günstiger. Jedoch lohnen sich im Vergleich zum nur für ein Jahr laufenden einjährigen Plan die 2 Jahre erst nach ca. 22 Monaten (Summe der beiden dunkelgrünen Felder und deren Monate vs. gelbe Felder)!

Man könnte also sagen:

- Bei einer geplanten Laufzeit ab ca. 26 Monaten ist der beste Weg der Savings Plan für 3 Jahre

- Bei einer geplanten Laufzeit zwischen 22 und 25 Monaten ist es sinnvoll, 2 Jahre lang einen einjährigen Plan zu buchen

- Bei einer geplanten Laufzeit zwischen 10 und 21 Monaten bucht man einen einjährigen Plan für ein Jahr – den Rest der Laufzeit zahlt man dann einfach per Pay-per-Use

- Bei einer geplanten Laufzeit von 9 Monaten oder weniger ist Pay-per-Use der besser Weg

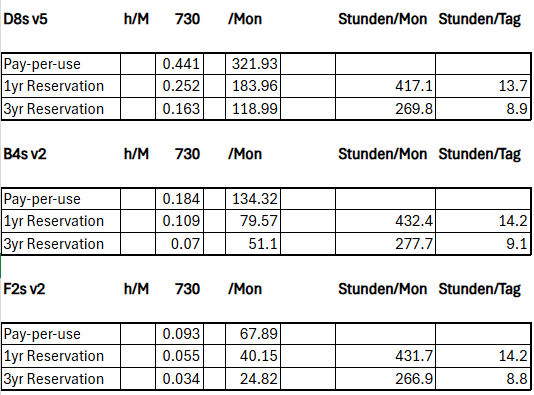

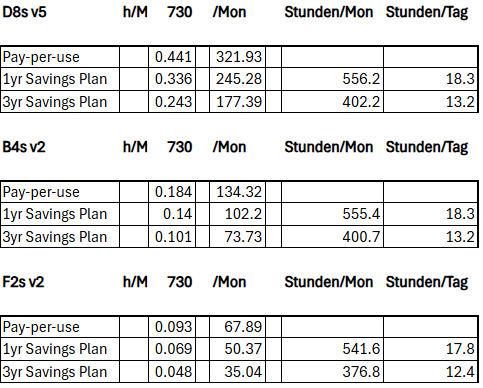

Wenn wir uns nun der zweiten Frage, nämlich ab wie vielen Stunden täglichen Betriebes über die gesamte Laufzeit sich welcher Plan lohnt, dann sieht es folgender Maßen aus:

Hier können wir sehen, dass…

- …es für einen einjährigen Plan ca. 18h…

- …es für einen dreijährigen Plan ca. 13h…

…täglich sein müssten.

Auch hier gilt also, dass man problemlos auch dann noch gut mit einem Savings Plan fährt, wenn man die Systeme für einige Stunden am Tag ausschaltet („Snoozing“), vor allem beim dreijährigen Plan. Denn in dieser Zeit spart man dann ja auch noch zusätzlich die Kosten für etwaige Betriebssystem-Lizenzen, wenn diese nicht durch Hybrid Benefit abgedeckt sind.

Weiterhin gilt auch hier, dass, sobald wir mehr als nur das eine angenommene System haben, die Amortisierung in der Regel noch früher eintritt. Dennoch rate ich auch beim Savings Plan dazu, nicht alle vorhandenen Systeme damit abzudecken, um noch etwas Flexibilität zu erhalten!

Fazit

Mit Savings Plans lassen sich im Vergleich zu Pay-per-Use gute Ersparnisse erzielen. Auch wenn die Rabatte im Vergleich zu Reservierungen zum Teil deutlich geringer sind – man bekommt dafür etwas mehr Freiheiten bei der Nutzung. Und auch wenn man sich nicht auf eine konkrete VM-SKU festlegen muss – eine Optimierung (insbesondere Rightsizing) sollte vor dem Buchen der Savings Plans erfolgen, damit man keine zu hohen Beträge verbindlich fixiert, unter die man dann später auch durch Optimierungen nicht mehr drunter kommt.

Schreibe einen Kommentar...