Da in einigen Projekten der letzten Zeit bei mir immer mal wieder die Frage auftaucht, ob man nun Reservierungen oder Savings Plans (konkret für VMs) buchen solle, will ich das Thema hier nochmal aufgreifen und etwas umfangreicher behandeln.

Als kurze Wiederholung – worum handelt es sich hier eigentlich?

Bei Reservierungen (oder Reserved Instances) bucht man eine spezifische VM SKU (oder zumindest eine konkrete Serie, dazu unten mehr) für eine bestimmte Azure Region, ggf. für einen spezifischen Scope (z.B. eine bestimmte Subscription) auf ein oder drei Jahre. Dafür erhält man diese Leistung dann zu einem stark rabattierten Preis. Die Kosten kann man entweder monatlich oder direkt einmal vollständig im Voraus zahlen.

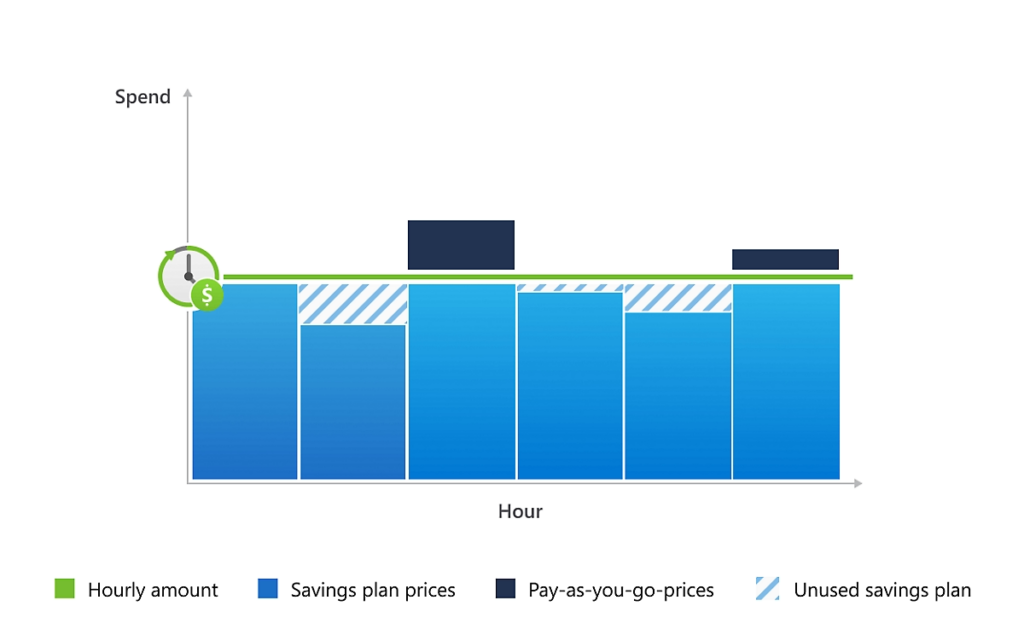

Bei einem Savings Plan zahlt man einen selbst gewählten Betrag ein. Dabei legt man weder eine SKU, noch eine Region fest. Man muss sich noch nicht einmal für einen konkreten Service festlegen, wenngleich Savings Plans nur für eine kleine Liste von Diensten gelten (insb. VMs, VMSS, AKS, App Services). Dafür erhält man Leistungen zu einem rabattierten Preis. Welche das sind, wird von Microsoft danach entschieden, welche passenden Dienste im Scope des Savings Plans den größten Preisnachlass durch den Plan haben. Im Prinzip zahlt man hier einen gewissen Betrag ein, den Microsoft dann „verzinst“ und aus dem verzinsten Guthaben dann Leistungen bezahlt.

Es gibt hier also zwei ganz wesentliche Unterschiede:

| Reservierung | Savings Plan |

| Gilt für eine ganz bestimmte VM SKU oder ggf. eine bestimmte VM Serie. | Gilt für alle unterstützen Azure Services im Scope. |

| Gilt nur für die bei der Buchung festgelegte Azure Region | Gilt unabhängig von einer Region. |

Nun kommt aber ein weiterer Aspekt (zumindest derzeit noch, und keiner weiss wie lange) dazu: Die Verbindlichkeit!

Eine Reservierung für VMs ist zwar sehr spezifisch in ihrer Gültigkeit (Region, VM SKU), kann allerdings geändert werden (Exchange, also der Umtausch in eine andere Reservierung, Trade-In, also das Eintauschen gegen einen Savings Plan, oder Cancelation, also das Stornieren einer Reservierung bis zu einem maximalen Betrag von 50.000 USD).

(Siehe hierzu Changes to the Azure reservation exchange policy – Microsoft Cost Management | Microsoft Learn)

Und auch wenn man sich für eine spezifische VM SKU entscheiden muss, gibt es für Reservierungen eine (mittlerweile standardmäßig aktivierte) Flexibilitäts-Option. Ist diese aktiv, kann eine Reservierung auch für andere VMs der selben „Instance Size Flexibility Group“ genutzt werden. Vereinfacht gesagt kann man dann eine andere VM der selben Serie einsetzen und die gebuchten Kerne werden entsprechend umgerechnet. So kann man dann z.B. in einer gebuchten Instanz der D8s_v5 auch alternativ 2 Instanzen der D4s_v5 betreiben. Man bleibt aber immer auf die selbe Serie und somit die selbe zugrunde liegende Hardware festgelegt!

Ein Savings Plan hingegen ist in sich deutlich flexibler in der Nutzung, da er unabhängig von einer speziellen VM SKU und auch unabhängig von einer Region verwendet werden. Allerdings gibt es für einen gebuchten Savings Plan keinerlei Möglichkeiten, diesen zu ändern. Er lässt sich weder verkleinern noch stornieren. Man kann lediglich weitere Savings Plans hinzubuchen. Er bringt somit also in letzter Konsequenz eine gefühlte höhere Verbindlichkeit mit sich!

Nun stellt sich natürlich die Frage, für welche der beiden Optionen man sich entscheiden sollte. Das kann man zwar nicht pauschal beantworten, aber es gibt einige wesentliche Aspekte, die man berücksichtigen sollte:

- Da eine Reservierung für eine spezifische Hardware (und somit ein spezielles CPU-Modell) gilt, sollte man diese nicht für alte VM SKUs buchen, weil dadurch eine Modernisierung erschwert wird. (Für VM-SKUs, die bereits abgekündigt sind, kann z.T. auch keine Reservierung mehr gebucht werden).

- Für Workloads, die zwar heute noch als klassische VM betrieben werden, für die aber eine Modernisierung z.B. hin zu Kubernetes angedacht ist, sind Savings Plans in der Regel die bessere Option, da diese auch nach der Modernisierung weiterhin genutzt werden können.

- Reservierungen bieten den größeren Rabatt als Savings Plans. Wenn es also keinen Grund zur Annahme gibt, dass die genutzten VM-Typen nicht mindestens für die Dauer der Reservierung genutzt werden, dann ist eine Reservierung kaufmännisch oft lohnender.

Und gerade zum letzten Punkt, nämlich den Rabatten bzw. Kosten, will ich noch etwas aufzeigen!

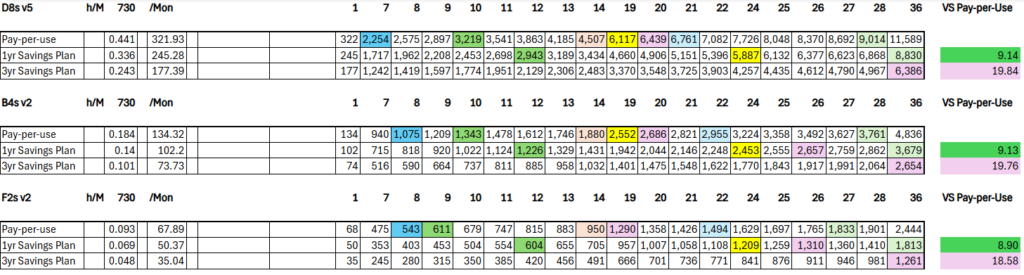

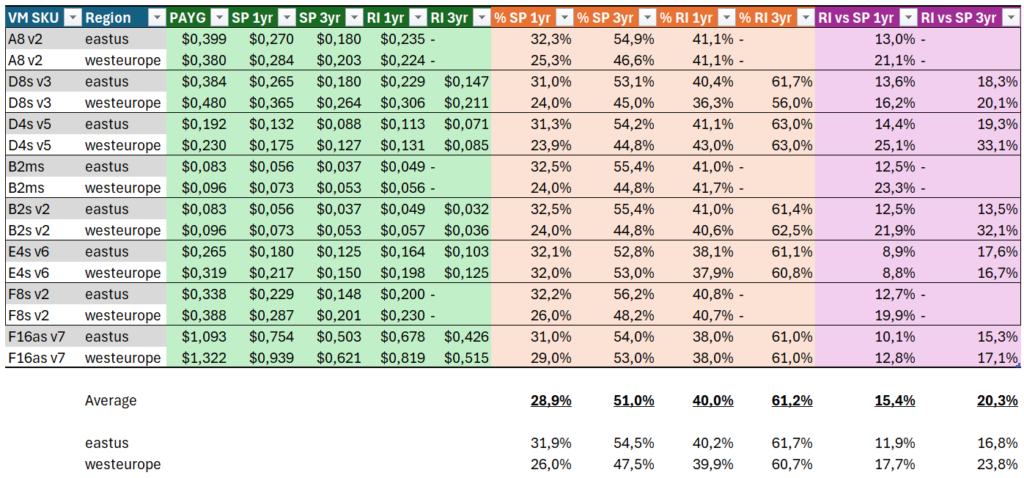

In der nachfolgenden Tabelle sind für einige ausgewählte VM-SKUs die Preise und Rabatte für West Europe und East U.S. dargestellt:

Hierbei kann man einiges feststellen:

- Reservierungen haben einen nahezu durchgehend gleichhohen Rabatt, unabhängig von Region und VM-Serie. Er liegt bei 1-jährigen Reservierungen bei ca. 40% (mit leichten Abweichungen bei sehr neuen Serien) und bei ca. 60% bei 3-jährigen Reservierungen.

- Savings Plans unterscheiden sich vor allem bei den etwas älteren VM-Serien recht deutlich zwischen den Regionen. Während es in West Europe nur etwa 25% Rabatt gibt, sind es in East U.S. über 30%.

- Somit bringen Reservierungen in West Europe zwischen 8% (Es_v6 für 1 Jahr) und 33% (Ds_v5 für 3 Jahre) mehr Rabatt als Savings Plans.

- In East U.S. sind es hingegen nur zwischen 8% und ca. 20% (D2_v5 für 3 Jahre).

- Ergo: In West Europe lohnen sich Reservierungen oft deutlich stärker, als in East U.S.

- Bei neueren VM-Serien sind gerade in West Europe die Rabatte bei Reservierungen nur noch geringfügig höher als bei Savings Plans der selben Laufzeit (z.B. E4s_v6 auf ein Jahr: 32% vs. 37%!)

Es kommt also auch sehr stark auf die vorgesehene Region und die eingesetzten VM-Serien an, wenn es darum geht, zu entscheiden, welcher Weg der bessere ist!

Ich hoffe, diese Analyse hilft euch etwas besser, die Entscheidungen für Reservierungen und Savings Plans zu treffen…

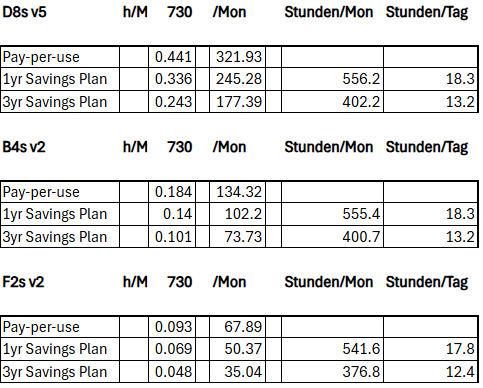

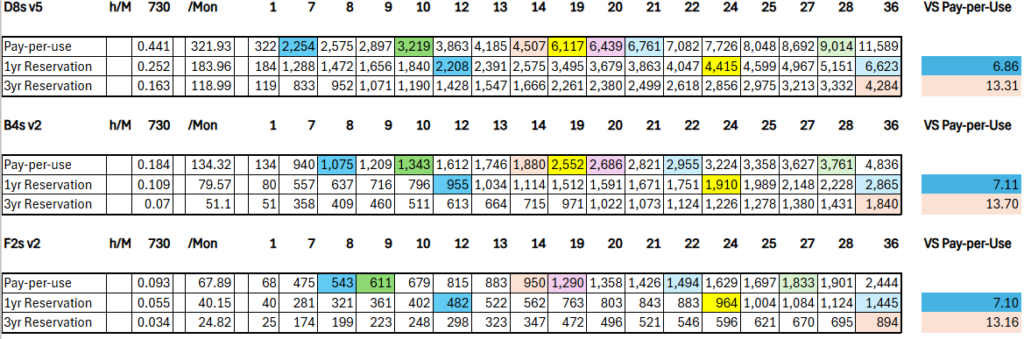

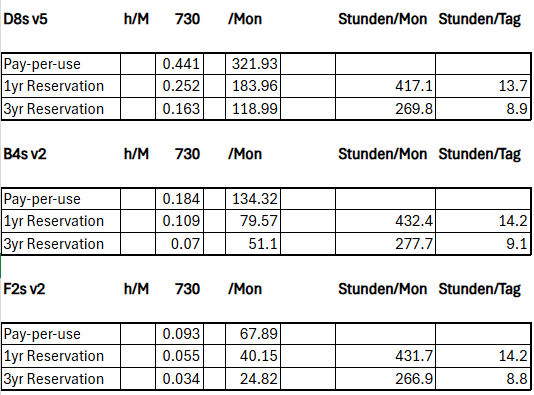

PS: Schaut euch bezüglich der Frage, ab wann sich Reservierungen und Savings Pläne generell lohnen, auch gerne meine vorhergegangenen Beiträge zu diesem Thema an. (Kosten sparen in Azure – Reservierungen und Kosten sparen in Azure – Savings Plans).

Schreibe einen Kommentar...